Vendredi dernier, nous avons partagé une grande nouvelle avec les référenceurs du monde entier : Google a officiellement annoncé la sortie de sa mise à jour Penguin 4.0. Penguin fait désormais partie de l’algorithme central de Google et fonctionne en temps réel.

Avant de voir quel impact ces changements auront sur l’industrie de la recherche, faisons un retour en arrière.

Le monde a entendu parler pour la première fois de la mise à jour Penguin en avril 2012. Son objectif principal était de s’occuper des sites Web qui avaient acquis des liens de manière non naturelle afin d’améliorer leur classement. Après la mise en œuvre de cette mise à jour, qui a touché environ 3,1 % des requêtes, de nombreux sites Web ont été pénalisés par Google et ont ainsi disparu des moteurs de recherche. Ainsi, les règles du jeu ont complètement changé, et une toute nouvelle ère dans le link building a commencé.

Se remettre d’une pénalité Google a toujours pris beaucoup de temps, et la nouvelle version de Penguin que Google a déployée le 23 septembre a apporté des changements significatifs. « Historiquement, la liste des sites affectés par Penguin était périodiquement rafraîchie au même moment. Maintenant, Penguin est en temps réel, donc les changements seront visibles beaucoup plus rapidement, prenant généralement effet peu de temps après que nous ayons recrawlé et réindexé une page « , a écrit Gary Illyes sur le blog Google Webmaster.

Passons en revue les principales caractéristiques de Penguin 4.0 et voyons comment elles affecteront le travail des spécialistes du référencement :

-

Penguin 4.0 a été publié pour tous les pays et toutes les langues en même temps. Cela signifie que tous les sites web subiront le même impact indépendamment de leur localisation ; les règles sont les mêmes pour tous.

-

Penguin est désormais en temps réel. Cela implique que le classement de n’importe quelle page de nombreux changements chaque fois que Google met à jour les informations sur cette page et sur les pages qui y sont liées. Ainsi, les impacts positifs et négatifs de vos actions seront perceptibles plus rapidement.

-

L’algorithme en temps réel vous permet de vous remettre plus rapidement d’une pénalité de Google. Si votre site est pénalisé et que votre webmaster fait un bon travail pour l’améliorer et supprimer les liens nuisibles, vous verrez des résultats positifs plus rapidement, juste après que Google ait recrawlé les pages de votre site.

-

Désormais, Pingouin fait partie de l’algorithme principal de Google, et non d’un filtre séparé. C’est pourquoi nous avons vu la dernière annonce officielle de Google concernant cette mise à jour. Vous devrez désormais surveiller en permanence votre profil de backlink.

-

Penguin devient plus granulaire. Pour faire simple, l’algorithme se concentre désormais sur les pages spécifiques vers lesquelles pointent les liens toxiques, plutôt que sur l’ensemble des sites web. Ces micro-pénalités sont plus difficiles à suivre, c’est pourquoi il est désormais essentiel d’auditer régulièrement tous les sous-domaines importants et les pages spécifiques de votre site web.

Comment bénéficier de Penguin 4.0?

L’une des raisons pour lesquelles Penguin est si dangereux est que vous ne serez jamais informé si votre site web est pénalisé. Vous ne pouvez que supposer que vous avez été pénalisé par des signes indirects, comme une forte baisse du trafic organique ou des positions déclinées pour certains (ou tous) de vos mots-clés, y compris ceux de marque.

Parce que l’algorithme mis à jour vous permet de voir rapidement les résultats de vos actions, il peut être une arme à double tranchant. Le processus de récupération devient plus rapide, mais le processus de pénalisation aussi. Voici ce que vous pouvez faire pour protéger votre site Web contre les baisses inattendues de classement :

-

Surveillez constamment vos positions dans les SERP. Configurez des alertes email régulières pour rester informé de tout changement de position. Assurez-vous de suivre non seulement les mots-clés pour lesquels votre page d’accueil est classée, mais aussi les mots-clés de toutes les subdivisions importantes. Tom Clark suggère de « comparer les classements des mots clés et d’enquêter sur les mots clés qui ont pris une baisse soudaine de leur position. »

-

Gardez votre profil de backlink sain et propre. Prenez l’habitude de vérifier régulièrement les backlinks nouveaux et perdus, leur valeur et leur qualité, et de traiter ceux qui sont suspects.

-

Conduisez un audit approfondi des backlinks de l’ensemble de votre site web. Parce que le nouveau Pingouin adopte une approche granulaire, il est essentiel d’auditer les backlinks pour chaque sous-domaine et subdivision importante de votre site Web (par exemple, effectuer un audit distinct pour chacune des différentes versions linguistiques de votre site Web).

-

Mettez en place des propriétés dans Google Search Console pour chaque sous-domaine ou subdivision importante et mettez à jour votre fichier de désaveu si nécessaire. Vous pouvez utiliser l’outil SEMrush Backlink Audit pour formater facilement et correctement les fichiers de désaveu.

La mise à jour Penguin et l’avenir du link building

En général, la fonctionnalité « en temps réel » de Penguin implique que vous pouvez vous remettre de la pénalité plus rapidement. La nouvelle mise à jour vous permet de mener diverses expériences avec un coût d’erreur réduit – tant que vous êtes compétent et prudent.

Cependant, cela pourrait en théorie conduire les SEO avisés à essayer de tricher avec le système et de manipuler à nouveau les résultats des SERP – par exemple, en acquérant artificiellement des backlinks pour des sous-domaines ou des URL concrets et en observant la réaction de Google à leurs expériences. Nous avons demandé à certains experts de partager leur opinion si la nouvelle mise à jour Penguin va conduire à une nouvelle vague d’optimisation grise.

Je soupçonne que la nature en temps réel rendra difficile pour les spammeurs de savoir s’ils ont été touchés par Panda, Penguin ou autre. Je ne suis donc pas sûr que cela rendra les choses plus faciles ou plus difficiles. Le temps nous le dira.

En bref, non. Je ne crois pas que le Pingouin passant à l’algorithme de base et fonctionnant en « temps réel » conduira à plus d’optimisation grey-hat, pour deux raisons :

1. Le temps réel n’est pas instantané.

Même si Google utilise le langage « temps réel », il y aura toujours un temps de latence pour voir les résultats des liens nouvellement sécurisés. En théorie, cela ne se produira que lorsque Google crawlera à la fois votre page et la page qui renvoie à votre site.

2. Google a déclaré que cette mise à jour rendait Pingouin « plus granulaire ».

Le langage exact utilisé par Google pour décrire la nature granulaire de Pingouin : « Penguin dévalue désormais le spam en ajustant le classement en fonction des signaux de spam, plutôt que d’affecter le classement de l’ensemble du site. »

Certains référenceurs ont émis la théorie que le nouvel algorithme Penguin pourrait simplement ignorer les liens de spam, plutôt que d’appliquer une mesure punitive. L’algorithme Penguin affecterait davantage les pages que les sites, selon la déclaration de Google. Cela permettrait de vaincre en grande partie le référencement négatif, mais aussi d’obscurcir davantage l’effet des liens grey hat conçus pour tester et manipuler Penguin.

En bref, je pense qu’il sera extrêmement difficile de réellement mesurer et comprendre l’effet des liens manipulateurs sur l’algorithme Penguin. Google a tendance à s’améliorer avec le temps, et je pense que cette nouvelle mise à jour va poursuivre cette tendance.

Je pense qu’il y a deux choses à craindre avec cette nouvelle mise en œuvre de Pingouin.

Google a effectivement redonné le pouvoir d’expérimenter (et peut-être de manipuler l’algorithme) à ceux qui ont la capacité d’y consacrer du temps et des ressources. Je vois deux groupes clés qui pourraient être susceptibles d’en profiter d’une manière qui pourrait être préjudiciable, à la fois pour les concurrents et pour la qualité générale des SERPs.

Premièrement, ceux qui ont un penchant pour repousser les limites expérimentales afin d’obtenir des aperçus sur le fonctionnement de l’algorithme de base de Google. Pour ces personnes, les inconnus peuvent maintenant être testés, les limites repoussées et les SERPs impactés une fois de plus.

Peut-être plus inquiétant est le spectre de donner aux opérateurs malveillants la capacité de vraiment tester l’efficacité des efforts de référencement négatif. Alors que l’objectif déclaré de Google a toujours été de faire en sorte que l’algorithme Penguin soit immunisé contre le référencement négatif, les premiers signes ne sont pas très bons. Le premier client à m’avoir contacté après la publication du nouvel algorithme Pingouin était un propriétaire d’entreprise qui observait depuis des mois la construction d’un nombre massif de liens spammy vers son site, les ignorant sur les conseils de ceux qui pensaient que « Google est généralement très bon pour identifier le référencement négatif ». Vingt-quatre heures après la publication, son site avait subi une baisse significative de sa visibilité.

Bien que je sois heureux d’avoir enfin un Pingouin plus réactif dans le quartier, il y a beaucoup de choses à surveiller au fur et à mesure que tout cela se met en place. En attendant, nous continuerons à nous concentrer sur l’aide à apporter à ceux qui ont affaire à des actions manuelles, pour qui rien ne change sans un travail acharné et une attention particulière aux détails.

Nous apprenons de plus en plus chaque jour avec Pingouin, ce qui est génial. J’ai dit l’autre jour que le désaveu ne serait probablement plus nécessaire, et j’avais raison ! Gary l’a confirmé hier. Et puis il a expliqué que les pénalités précédentes de Penguin (suppression) étaient supprimées dans les prochains jours. C’est une ENORME nouvelle.

En tout cas, je vais attendre jusqu’à ce que plus de données arrivent. J’ai fortement analysé de nombreux domaines qui ont été précédemment impactés. Je pense que la semaine prochaine sera très intéressante.

Bien qu’il soit un peu tôt pour évaluer cette nouvelle, il y a quelques aspects intéressants : le Pingouin devient une partie de l’algorithme de base de Google et devient donc un facteur de classement. Si c’est vrai, cela signifie que dès que quelqu’un essaie de tromper Google, l’algorithme ajuste immédiatement les classements. Dans Bruce Clay, nous analysons cet impact réel, et nous aurons plus de données et d’analyses fin octobre.

Je ne pense pas que quoi que ce soit que Google ait jamais fait ait empêché les SEO de trouver des moyens de tromper le système ! Mais oui, je peux voir comment Penguin 4.0 pourrait être un avantage pour les SEOs qui expérimentent les liens artificiels. Tout le monde en parle depuis l’annonce de Penguin 4.0, mais il est trop tôt pour savoir si c’est vraiment le cas.

Les SEO grisonnants devront certainement adapter leurs procédés, les SEO black-hat aussi. C’est comme l’utilisation de drogues en athlétisme ; à moins d’être surhumain, vous savez que pour gagner vous devrez peut-être augmenter artificiellement vos performances, mais si vous vous faites prendre, votre carrière pourrait être terminée pour toujours. Ce qui est plus inquiétant pour moi, c’est que la granularité de Penguin 4.0 pourrait faciliter la prise de contrôle des SERPs par des SEO négatifs pour un mot-clé ou une micro-niche en particulier sans être détectés.

5 erreurs courantes commises lors du désaveu des liens

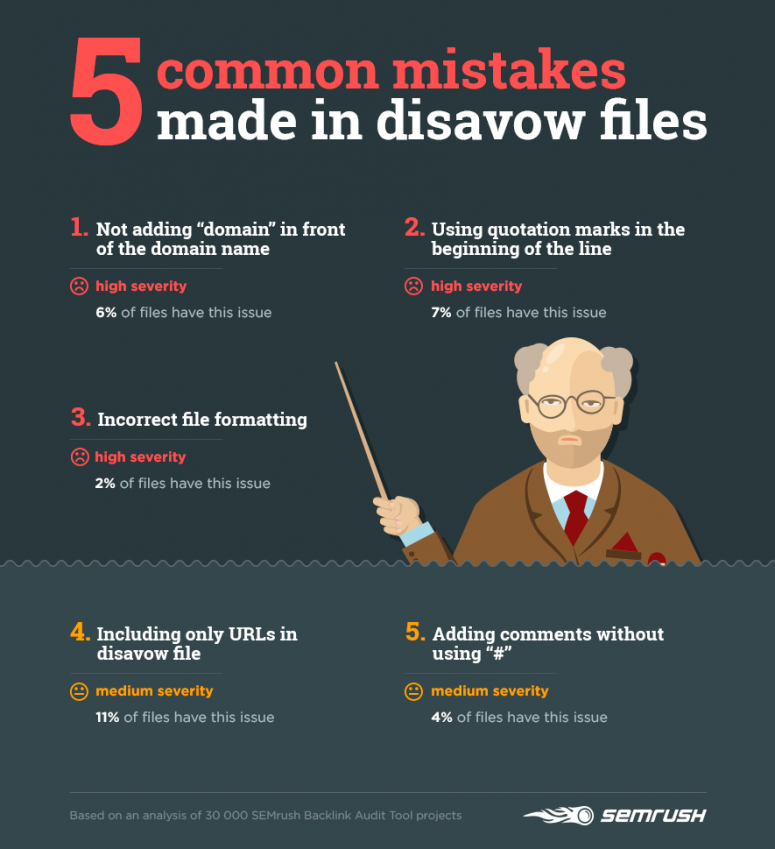

J’ai déjà souligné qu’être en temps réel Penguin 4.0. rend absolument essentiel de surveiller régulièrement vos backlinks et de vous débarrasser de ceux qui sont dangereux. Nous avons analysé 30 000 campagnes créées dans l’outil SEMrush Backlink Audit afin de voir comment les SEO désavouent les liens et d’identifier leurs erreurs les plus courantes.

21 % des fichiers de désaveu que nous avons recherchés ne sont pas conformes aux règles de Google Search Console. Examinons les erreurs les plus fréquentes :

1) Ne pas ajouter « domain » devant le nom de domaine lors du désaveu des liens d’un domaine entier

Google ne reconnaît que les lignes qui commencent par http ou domain. Si vous écrivez www.domain.com, Google ignorera cette ligne et ne la désavouera pas.

Correct : domaine : mondomaine.com

Incorrectif : mondomaine.com

2) Utiliser des guillemets en début de ligne

Encore, Google ignorera simplement une ligne qui commence par n’importe quoi sauf http ou domaine.

Correct : http://www.domain.com/index.html

Incorrect : ‘http://www.domain.com/index.html’

3) Formatage incorrect du fichier

L’utilisation d’un séparateur de ligne incorrect dans certains outils peut entraîner la fusion de données de plusieurs lignes en une seule. Google ne sera pas en mesure de reconnaître le fichier correctement et d’appliquer les règles de désaveu.

4) Inclure uniquement les URL dans le fichier de désaveu

Parfois, un lien d’un seul article peut apparaître sur quelques autres pages d’un site Web – par exemple, les pages présentant les meilleurs articles du mois, les articles par catégorie, etc. Ainsi, si vous voulez vous assurer que Google ne prend pas en compte le lien entre votre site Web et un site Web spécifique, désavouer une URL particulière n’est pas suffisant. Vous devez désavouer ce domaine entier.

5) Ajouter des commentaires sans utiliser « # »

Commenter votre fichier de désaveu n’est pas obligatoire. Cependant, si vous décidez de fournir des informations supplémentaires, assurez-vous qu’elles n’empêchent pas Google d’analyser votre fichier.

Après avoir téléchargé votre fichier de désaveu, vérifiez toujours combien de lignes Google a reconnu correctement. Si le nombre ne correspond pas au nombre de lignes de votre requête, vérifiez la conformité du fichier avec les règles du SGC.

Nous vous recommandons de commencer à auditer votre profil de backlink dès que possible et de vous habituer à le faire régulièrement.

.