Förra fredagen delade vi med oss av stora nyheter till SEO:s över hela världen: Google har officiellt tillkännagivit lanseringen av Penguin Update 4.0. Penguin blir nu en del av Googles kärnalgoritm och körs i realtid.

Innan vi ser vilken inverkan dessa förändringar kommer att ha på sökbranschen, ska vi ta en titt tillbaka.

Världen hörde för första gången talas om Penguin-uppdateringen i april 2012. Dess främsta syfte var att ta itu med webbplatser som hade skaffat sig länkar på ett onaturligt sätt för att öka sina placeringar. Efter att Google rullade ut den här uppdateringen, som påverkade cirka 3,1 procent av sökningarna, utsattes mängder av webbplatser för en Google-bestraffning och föll bort från sökningarna till följd av detta. Därmed ändrades spelreglerna helt och hållet, och en helt ny era inom länkbyggande inleddes.

Att återhämta sig från en Google-bestraffning har alltid tagit lång tid, och den nya versionen av Penguin som Google rullade ut den 23 september medförde några betydande förändringar. ”Historiskt sett uppdaterades listan över webbplatser som påverkades av Penguin regelbundet vid samma tidpunkt. Nu är Penguin i realtid, så ändringarna kommer att bli synliga mycket snabbare och träder vanligtvis i kraft kort efter att vi har rekrawlat och återindexerat en sida”, skrev Gary Illyes på Googles Webmaster-blogg.

Låt oss gå igenom de viktigaste funktionerna i Penguin 4.0 och se hur de kommer att påverka SEO-specialisternas arbete:

-

Penguin 4.0 släpptes för alla länder och språk samtidigt. Det innebär att alla webbplatser kommer att uppleva samma påverkan oberoende av var de befinner sig. Reglerna är desamma för alla.

-

Penguin är i realtid nu. Detta innebär att varje sidas rankning många ändras varje gång Google uppdaterar informationen om denna sida och om sidor som länkar till den. Så både de positiva och negativa effekterna av dina åtgärder kommer att bli märkbara snabbare.

-

Erealtidsalgoritmen gör att du kan återhämta dig snabbare från en Google-bestraffning. Om din webbplats bestraffas och din webmaster gör ett bra jobb med att förbättra den och ta bort skadliga länkar kommer du att se positiva resultat tidigare, direkt efter att Google har dragit tillbaka webbplatsens sidor.

-

Från och med nu är Penguin en del av Googles kärnalgoritm, inte ett separat filter. Det är därför vi har sett det sista officiella Google-meddelandet om uppdateringen. Nu måste du kontinuerligt övervaka din backlinkprofil.

-

Penguin blir mer detaljerad. Enkelt uttryckt fokuserar algoritmen nu på de specifika sidor som giftiga länkar pekar på, snarare än på hela webbplatser. Sådana mikrobestraffningar är svårare att spåra, varför det nu är viktigt att regelbundet granska alla viktiga underdomäner och specifika sidor på din webbplats.

Hur kan man dra nytta av Penguin 4.0?

En av anledningarna till att Penguin är så farlig är att du aldrig får veta om din webbplats bestraffas. Du kan bara anta att du straffats genom indirekta tecken, som en kraftig minskning av den organiska trafiken eller försämrade positioner för vissa (eller alla) av dina sökord, inklusive de märkesbaserade.

Då den uppdaterade algoritmen gör det möjligt för dig att snabbt se resultaten av dina åtgärder, kan den vara ett tveeggat svärd. Återhämtningsprocessen blir snabbare, men det gör även bestraffningsprocessen. Här är vad du kan göra för att skydda din webbplats från oväntade nedgångar i rankingen:

-

Kontrollera ständigt dina positioner i SERPs. Ställ in regelbundna e-postvarningar för att hålla dig informerad om eventuella positionsförändringar. Se till att du inte bara spårar nyckelord som din hemsida rankas för, utan även nyckelord för alla viktiga underavdelningar. Tom Clark föreslår att du ”jämför nyckelordsrankningar och undersöker vilka nyckelord som har tagit en plötslig nedgång i sin position.”

-

Håll din backlinkprofil sund och ren. Gör det till en vana att regelbundet kontrollera nya och förlorade backlänkar, deras värde och kvalitet och hantera de misstänkta.

-

Gör en djupgående backlinkgranskning av hela din webbplats. Eftersom den nya pingvinen har ett granulärt tillvägagångssätt är det viktigt att granska backlinks för varje viktig underdomän och underavdelning av din webbplats (genomför till exempel en separat granskning för var och en av de olika språkversionerna av din webbplats).

-

Inställ egenskaper i Google Search Console för varje viktig underdomän eller underväg och uppdatera din disavow-fil vid behov. Du kan använda SEMrush Backlink Audit-verktyget för att enkelt och korrekt formatera disavow-filer.

Penguin-uppdateringen och framtiden för länkbyggande

I allmänhet innebär Penguins ”realtids”-funktion att du kan återhämta dig snabbare från en straffavgift. Den nya uppdateringen gör det möjligt att genomföra olika experiment med en minskad felkostnad – så länge man är kompetent och försiktig.

Detta kan dock i teorin leda till att smarta SEO:er återigen försöker lura systemet och manipulera SERP-resultaten – till exempel genom att på konstgjord väg skaffa sig backlänkar för konkreta subdomäner eller webbadresser och observera Googles reaktion på deras experiment. Vi har bett några experter att dela med sig av sin åsikt om den nya Penguin-uppdateringen kommer att leda till en ny våg av gråhatsoptimering.

Jag misstänker att realtidsnaturen kommer att göra det svårt för spammare att veta om de drabbats av Panda, Penguin eller något annat. Så jag är inte säker på om det kommer att göra det lättare eller svårare. Tiden får utvisa det.

Kort sagt, nej. Jag tror inte att Penguin som flyttas till kärnalgoritmen och körs i ”realtid” kommer att leda till mer gråhattoptimering, av två skäl:

1. Realtid är inte omedelbart.

Även om Google använder språket ”realtid” kommer det fortfarande att finnas en fördröjning innan man ser resultaten av nyligen säkrade länkar. I teorin kommer det att ske först när Google crawlar både din sida och den sida som länkar till din webbplats.

2. Google uppgav att den här uppdateringen gjorde Penguin ”mer granulär”.

Det exakta språket som Google använde för att beskriva den granulära karaktären hos Penguin: ”Penguin nedvärderar nu skräppost genom att justera rankningen baserat på skräppostsignaler, snarare än att påverka rankningen av hela webbplatsen.”

En del SEO:s har teoretiserat att den nya Penguin-algoritmen kanske helt enkelt ignorerar skräppostlänkar, i stället för att tillämpa en bestraffningsåtgärd. Penguin-algoritmen skulle enligt Googles uttalande påverka sidor mer än webbplatser. Detta skulle till stor del besegra negativ SEO, men också ytterligare fördunkla effekten av gråhattlänkar som utformats för att testa och manipulera Penguin.

Samt sett tror jag att det kommer att bli extremt svårt att faktiskt mäta och förstå effekten av manipulativa länkar på Penguin-algoritmen. Google tenderar att bli bättre med tiden, och jag tror att den här nya uppdateringen kommer att fortsätta den trenden.

Jag tror att det finns ett par saker att oroa sig för med den här nya implementeringen av Penguin.

Google har i själva verket gett makten att experimentera (och kanske manipulera algoritmen) tillbaka till dem som har möjlighet att lägga tid och resurser på det. Jag ser två huvudgrupper som sannolikt skulle kunna dra nytta av detta på ett sätt som kan vara skadligt, både för konkurrenter och för den allmänna kvaliteten på SERP:erna.

För det första de som har en förkärlek för att tänja på experimentella gränser för att få insikter om hur Googles kärnalgoritm fungerar. För dessa personer är det nu möjligt att testa okända saker, tänja på gränserna och återigen påverka de sökmotoriska resultaten.

Men det är kanske mer oroande att ge illasinnade operatörer möjlighet att verkligen testa effektiviteten av negativa SEO-insatser. Även om Googles uttalade mål alltid har varit att se till att Penguin-algoritmen är immun mot negativ SEO, är de första tecknen inte bra. Den första kunden som kontaktade mig efter lanseringen av den nya Penguin-algoritmen var en företagare som hade sett hur ett stort antal skräppostlänkar byggdes till hans webbplats i flera månader, men som ignorerade dem på inrådan av dem som trodde att ”Google generellt sett är väldigt bra på att identifiera negativ SEO”. Ett dygn efter lanseringen hade hans webbplats fått en betydande försämrad synlighet.

Även om det gläder mig att vi äntligen har fått en mer lyhörd Penguin, finns det mycket att se upp för när allt detta skakar fram. Under tiden fortsätter vi att fokusera på att hjälpa dem som har att göra med manuella åtgärder, för vilka ingenting förändras utan hårt arbete och uppmärksamhet på detaljer.

Vi lär oss mer och mer varje dag med Penguin, vilket är fantastiskt. Jag sa häromdagen att disavowing förmodligen inte skulle behövas längre, och jag hade rätt! Gary bekräftade det i går. Och sedan förklarade han att tidigare Penguin-straff (suppression) tas bort under de närmaste dagarna. Det är en STOR nyhet.

Ja, jag tänker avvakta tills mer data kommer in. Jag har analyserat många domäner som tidigare påverkats kraftigt. Jag tror att nästa vecka kommer att bli mycket intressant.

Och även om det är lite tidigt att utvärdera den här nyheten finns det ett par intressanta aspekter: Penguin blir en del av Googles kärnalgoritm och blir därför en rankingfaktor. Om det är sant innebär det att så snart någon försöker lura Google kommer algoritmen omedelbart att justera rankningen. I Bruce Clay analyserar vi denna faktiska påverkan, och vi kommer att ha mer data och analyser i slutet av oktober.

Jag tror inte att något som Google någonsin har gjort har stoppat SEO:s från att hitta sätt att fuska med systemet! Men ja, jag kan se hur Penguin 4.0 kan vara en fördel för SEO:er som experimenterar med artificiella länkar. Alla har pratat om detta sedan Penguin 4.0 tillkännagavs, men det är för tidigt att säga om detta verkligen är fallet.

Grey-hat SEOs kommer säkerligen att behöva anpassa sina processer, black-hat SEOs också. Det är som med droganvändning inom friidrotten; om man inte är övermänsklig vet man att man för att vinna kan behöva öka sina prestationer på konstgjord väg, men om man åker fast kan karriären vara över för alltid. Det mer oroande för mig är att granulariteten i Penguin 4.0 kan göra det lättare för negativa SEO:er att ta över SERPs för ett visst nyckelord eller en viss mikronisch utan att det upptäcks.

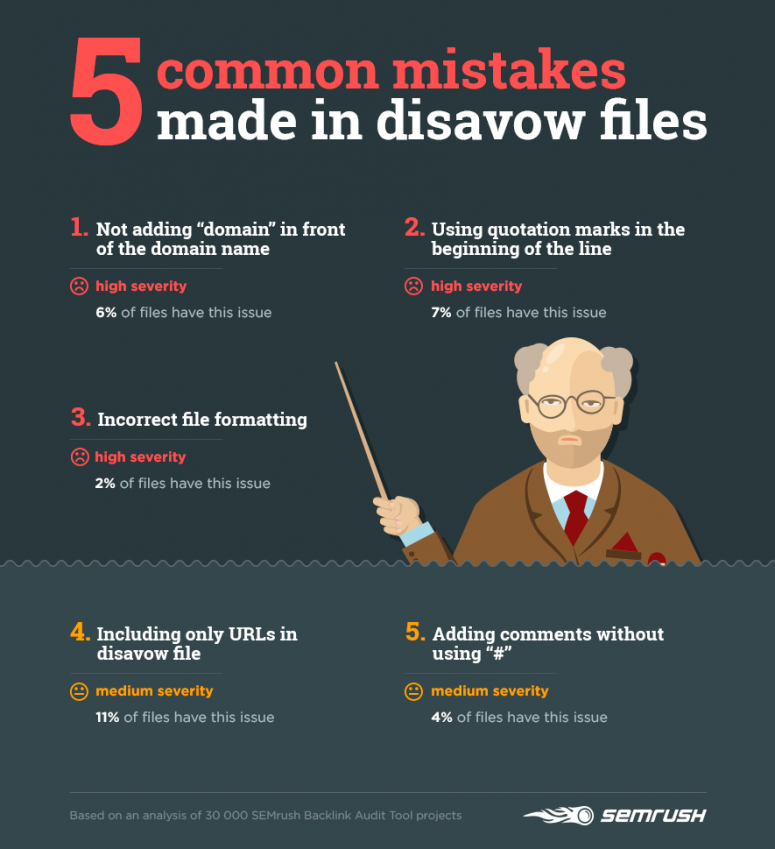

5 vanliga misstag som görs när man tar bort länkar

Jag har redan påpekat att det faktum att man är i realtid med Penguin 4.0. gör det absolut nödvändigt att regelbundet övervaka sina backlinks och göra sig av med farliga länkar. Vi har analyserat 30 000 kampanjer som skapats i verktyget SEMrush Backlink Audit för att se hur SEO:er disavowar länkar och identifiera deras vanligaste misstag.

21 procent av disavow-filerna som vi har undersökt följer inte reglerna i Google Search Console. Låt oss titta på de vanligaste misstagen:

1) Att inte lägga till ”domain” framför domännamnet när du tar bort länkar från en hel domän

Google känner bara igen rader som börjar med http eller domain. Om du skriver www.domain.com ignorerar Google denna rad och tar inte bort den.

Korrekt: domain: mydomain.com

Korrigerat: mydomain.com

2) Användning av citationstecken i början av en rad

Även här ignorerar Google helt enkelt en rad som börjar med något annat än http eller domain.

Korrigerat: http://www.domain.com/index.html

Inkorrekt: ’http://www.domain.com/index.html’

3) Felaktig filformatering

Användning av en felaktig linjeseparator i vissa verktyg kan leda till att data med flera rader slås ihop till en enda rad. Google kommer då inte att kunna känna igen filen korrekt och tillämpa reglerna för avstängning.

4) Endast webbadresser ingår i avstängningsfilen

Ibland kan en länk från en enskild artikel dyka upp på några andra sidor på en webbplats – till exempel sidor med månadens bästa inlägg, inlägg per kategori osv. Så om du vill försäkra dig om att Google inte tar hänsyn till kopplingen mellan din webbplats och en specifik webbplats räcker det inte med att ta bort en viss URL. Du måste ta avstånd från hela denna domän.

5) Lägg till kommentarer utan att använda ”#”

Det är inte obligatoriskt att kommentera din disavow-fil. Men om du bestämmer dig för att ge ytterligare information, se till att den inte hindrar Google från att analysera din fil.

När du har laddat upp din disavow-fil ska du alltid kontrollera hur många rader Google har identifierat korrekt. Om antalet inte stämmer överens med antalet rader i din begäran, kontrollera filen för att se om den överensstämmer med GSC:s regler.

Vi rekommenderar att du börjar granska din backlinkprofil så snart som möjligt och vänjer dig vid att göra det regelbundet.