Am vergangenen Freitag haben wir SEOs auf der ganzen Welt eine große Neuigkeit mitgeteilt: Google hat offiziell die Veröffentlichung des Penguin Updates 4.0 angekündigt. Pinguin wird nun Teil des zentralen Google-Algorithmus und läuft in Echtzeit.

Bevor wir sehen, welche Auswirkungen diese Änderungen auf die Suchindustrie haben werden, lassen Sie uns einen Blick zurück werfen.

Die Welt hörte zum ersten Mal vom Pinguin-Update im April 2012. Sein Hauptzweck war es, sich mit Websites zu befassen, die unnatürlich Links erworben hatten, um ihre Rankings zu verbessern. Nach der Einführung dieses Updates, das etwa 3,1 Prozent der Suchanfragen betraf, wurden zahlreiche Websites von Google abgestraft und fielen aus der Suche heraus. Damit änderten sich die Spielregeln völlig, und es begann eine ganz neue Ära des Linkbuildings.

Die Erholung von einer Google-Abstrafung hat immer lange gedauert, und die neue Version von Penguin, die Google am 23. September einführte, brachte einige bedeutende Änderungen mit sich. „In der Vergangenheit wurde die Liste der von Penguin betroffenen Websites in regelmäßigen Abständen zur gleichen Zeit aktualisiert. Jetzt arbeitet Penguin in Echtzeit, so dass Änderungen viel schneller sichtbar werden und in der Regel kurz nachdem wir eine Seite neu gecrawlt und indexiert haben, in Kraft treten“, schrieb Gary Illyes im Google Webmaster-Blog.

Werfen wir einen Blick auf die wichtigsten Funktionen von Penguin 4.0 und sehen wir, wie sie sich auf die Arbeit von SEO-Spezialisten auswirken werden:

-

Penguin 4.0 wurde für alle Länder und Sprachen gleichzeitig veröffentlicht. Das bedeutet, dass alle Websites unabhängig von ihrem Standort die gleichen Auswirkungen spüren werden; die Regeln sind für alle gleich.

-

Penguin ist jetzt in Echtzeit. Das bedeutet, dass sich die Platzierungen einer Seite jedes Mal ändern, wenn Google die Informationen über diese Seite und die Seiten, die auf sie verlinken, aktualisiert. So werden sowohl die positiven als auch die negativen Auswirkungen Ihres Handelns schneller spürbar.

-

Der Echtzeit-Algorithmus ermöglicht es Ihnen, sich schneller von einer Google-Abstrafung zu erholen. Wenn Ihre Website abgestraft wird und Ihr Webmaster gute Arbeit leistet, um sie zu verbessern und schädliche Links zu entfernen, werden Sie die positiven Ergebnisse früher sehen, gleich nachdem Google die Seiten Ihrer Website neu gezeichnet hat.

-

Ab sofort ist Penguin ein Teil des Kernalgorithmus von Google, kein separater Filter. Das ist der Grund, warum wir die letzte offizielle Google-Ankündigung zu diesem Update gesehen haben. Jetzt müssen Sie Ihr Backlink-Profil kontinuierlich überwachen.

-

Penguin wird immer granularer. Vereinfacht gesagt, konzentriert sich der Algorithmus jetzt auf die spezifischen Seiten, auf die giftige Links verweisen, und nicht mehr auf die gesamte Website. Solche Mikroabstrafungen sind schwieriger zu verfolgen, weshalb es jetzt unerlässlich ist, alle wichtigen Subdomains und spezifischen Seiten Ihrer Website regelmäßig zu überprüfen.

Wie kann man von Penguin 4.0 profitieren?

Einer der Gründe, warum Penguin so gefährlich ist, ist, dass Sie nie informiert werden, wenn Ihre Website abgestraft wird. Sie können nur davon ausgehen, dass Sie durch indirekte Anzeichen bestraft wurden, wie z. B. einen starken Rückgang des organischen Datenverkehrs oder eine Verschlechterung der Positionen für einige (oder alle) Ihrer Suchbegriffe, einschließlich der Markenbegriffe.

Da der aktualisierte Algorithmus es Ihnen ermöglicht, die Ergebnisse Ihrer Maßnahmen schnell zu sehen, kann er ein zweischneidiges Schwert sein. Der Wiederherstellungsprozess wird schneller, aber auch der Abstrafungsprozess. Hier ist, was Sie tun können, um Ihre Website vor unerwarteten Rankingverlusten zu schützen:

-

Überwachen Sie ständig Ihre Positionen in den SERPs. Richten Sie regelmäßige E-Mail-Benachrichtigungen ein, um über alle Positionsänderungen informiert zu sein. Vergewissern Sie sich, dass Sie nicht nur die Schlüsselwörter verfolgen, für die Ihre Homepage rangiert, sondern auch die Schlüsselwörter für alle wichtigen Unterabteilungen. Tom Clark schlägt vor, „die Keyword-Rankings zu vergleichen und zu untersuchen, welche Keywords einen plötzlichen Rückgang in ihrer Position erfahren haben“

-

Halten Sie Ihr Backlink-Profil gesund und sauber. Machen Sie es sich zur Gewohnheit, neue und verlorene Backlinks, ihren Wert und ihre Qualität regelmäßig zu überprüfen und die verdächtigen zu behandeln.

-

Führen Sie eine gründliche Backlink-Überprüfung Ihrer gesamten Website durch. Da der neue Penguin einen granularen Ansatz verfolgt, ist es unerlässlich, Backlinks für jede wichtige Subdomain und Unterabteilung Ihrer Website zu prüfen (führen Sie zum Beispiel für jede der verschiedenen Sprachversionen Ihrer Website eine separate Prüfung durch).

-

Richten Sie in der Google Search Console Eigenschaften für jede wichtige Subdomain oder jeden Unterpfad ein und aktualisieren Sie Ihre Disavow-Datei nach Bedarf. Sie können das SEMrush Backlink Audit Tool verwenden, um Disavow-Dateien einfach und korrekt zu formatieren.

Das Penguin Update und die Zukunft des Linkbuildings

Im Allgemeinen bedeutet die „Echtzeit“-Funktion von Penguin, dass Sie sich schneller von einer Abstrafung erholen können. Das neue Update ermöglicht es Ihnen, verschiedene Experimente mit geringeren Fehlerkosten durchzuführen – solange Sie kompetent und vorsichtig sind.

Theoretisch könnte dies jedoch dazu führen, dass versierte SEOs wieder versuchen, das System zu betrügen und SERP-Ergebnisse zu manipulieren – zum Beispiel, indem sie künstlich Backlinks für konkrete Subdomains oder URLs erwerben und Googles Reaktion auf ihre Experimente beobachten. Wir haben einige Experten nach ihrer Meinung gefragt, ob das neue Penguin-Update zu einer neuen Welle der Grey-Hat-Optimierung führen wird.

Ich vermute, dass es für Spammer aufgrund des Echtzeit-Charakters schwierig sein wird, zu erkennen, ob sie von Panda, Penguin oder etwas anderem getroffen wurden. Ich bin mir also nicht sicher, ob es dadurch einfacher oder schwieriger wird. Die Zeit wird es zeigen.

Kurz gesagt, nein. Ich glaube nicht, dass die Verlagerung von Penguin in den Kernalgorithmus und die Ausführung in „Echtzeit“ zu mehr Grey-Hat-Optimierung führen wird, und zwar aus zwei Gründen:

1. Echtzeit ist nicht gleichbedeutend mit sofortiger Wirkung.

Auch wenn Google die Formulierung „Echtzeit“ verwendet, wird es immer noch eine Verzögerung geben, bis die Ergebnisse der neu gesicherten Links sichtbar werden. Theoretisch geschieht dies nur, wenn Google sowohl Ihre Seite als auch die Seite, die auf Ihre Website verlinkt, crawlt.

2. Google erklärt, dass dieses Update Penguin „granularer“ macht.

Die genaue Sprache, die Google verwendet, um die granulare Natur von Penguin zu beschreiben: „Penguin wertet Spam jetzt ab, indem es das Ranking auf der Grundlage von Spam-Signalen anpasst, anstatt das Ranking der gesamten Website zu beeinflussen.“

Einige SEOs haben die Theorie aufgestellt, dass der neue Penguin-Algorithmus Spam-Links einfach ignorieren könnte, anstatt eine Strafmaßnahme zu ergreifen. Nach Googles Aussage würde der Penguin-Algorithmus eher Seiten als Websites betreffen. Damit wäre negatives SEO weitgehend besiegt, aber auch die Wirkung von Grey Hat-Links, die darauf abzielen, Penguin zu testen und zu manipulieren, würde weiter verschleiert.

Kurz gesagt, ich glaube, dass es äußerst schwierig sein wird, die Wirkung von manipulativen Links auf den Penguin-Algorithmus tatsächlich zu messen und zu verstehen. Google neigt dazu, mit der Zeit besser zu werden, und ich glaube, dass dieses neue Update diesen Trend fortsetzen wird.

Ich denke, dass es einige Dinge gibt, die bei dieser neuen Implementierung von Penguin zu beachten sind.

Google hat effektiv die Macht, zu experimentieren (und vielleicht den Algorithmus zu manipulieren), an diejenigen zurückgegeben, die die Fähigkeit haben, Zeit und Ressourcen darauf zu verwenden. Ich sehe zwei Hauptgruppen, die dies auf eine Art und Weise ausnutzen könnten, die sowohl für die Konkurrenten als auch für die allgemeine Qualität der SERPs nachteilig sein könnte.

Erstens, diejenigen mit einer Vorliebe dafür, die Grenzen des Experimentierens auszuloten, um Einblicke in die Funktionsweise des Kernalgorithmus von Google zu gewinnen. Für diese Leute ist es nun möglich, Unbekanntes auszuprobieren, Grenzen zu verschieben und die SERPs erneut zu beeinflussen.

Vielleicht ist die Befürchtung besorgniserregender, dass böswilligen Betreibern die Möglichkeit gegeben wird, die Wirksamkeit negativer SEO-Bemühungen wirklich zu testen. Obwohl es Googles erklärtes Ziel war, den Penguin-Algorithmus gegen negative SEO immun zu machen, sind die ersten Anzeichen nicht gut. Der erste Kunde, der sich nach der Veröffentlichung des neuen Penguin-Algorithmus an mich wandte, war ein Unternehmer, der monatelang beobachtet hatte, wie eine große Anzahl von Spam-Links zu seiner Website aufgebaut wurde, die er auf Anraten derjenigen ignorierte, die glaubten, dass „Google im Allgemeinen sehr gut darin ist, negative SEO zu erkennen“. Bereits vierundzwanzig Stunden nach der Veröffentlichung hatte seine Website einen erheblichen Verlust an Sichtbarkeit erlitten.

Ich freue mich zwar, dass es endlich einen reaktionsfreudigeren Pinguin gibt, aber es gibt noch viel zu beachten, wenn sich das alles einspielt. In der Zwischenzeit werden wir uns weiterhin darauf konzentrieren, denjenigen zu helfen, die mit manuellen Aktionen zu tun haben, für die sich ohne harte Arbeit und Liebe zum Detail nichts ändert.

Wir lernen jeden Tag mehr und mehr über Penguin, was großartig ist. Ich habe neulich gesagt, dass Disavowing wahrscheinlich nicht mehr nötig sein wird, und ich hatte Recht! Gary hat das gestern bestätigt. Und dann erklärte er, dass frühere Penguin-Abstrafungen (Unterdrückung) in den nächsten Tagen entfernt werden. Das sind GROSSE Neuigkeiten.

Allerdings werde ich mich zurückhalten, bis ich mehr Daten erhalte. Ich habe viele Domains, die zuvor betroffen waren, intensiv analysiert. Ich denke, die nächste Woche wird sehr interessant werden.

Es ist zwar noch etwas früh, um diese Nachricht zu bewerten, aber es gibt ein paar interessante Aspekte: Der Pinguin wird Teil des Google-Kernalgorithmus und damit zu einem Rankingfaktor. Wenn das stimmt, bedeutet das, dass sobald jemand versucht, Google zu täuschen, der Algorithmus die Rangliste sofort anpassen wird. In Bruce Clay analysieren wir diese tatsächliche Auswirkung, und wir werden Ende Oktober mehr Daten und Analysen haben.

Ich glaube nicht, dass irgendetwas, das Google jemals getan hat, SEOs davon abgehalten hat, Wege zu finden, das System zu betrügen! Aber ja, ich kann sehen, wie Penguin 4.0 ein Vorteil für SEOs sein könnte, die mit künstlichen Links experimentieren. Alle reden davon, seit Penguin 4.0 angekündigt wurde, aber es ist noch zu früh, um zu sagen, ob dies wirklich der Fall ist.

Grey-Hat-SEOs werden sicherlich ihre Prozesse anpassen müssen, Black-Hat-SEOs auch. Es ist wie beim Doping in der Leichtathletik: Wenn man nicht gerade ein Übermensch ist, weiß man, dass man seine Leistung künstlich steigern muss, um zu gewinnen, aber wenn man erwischt wird, kann die Karriere für immer vorbei sein. Besorgniserregender ist für mich, dass die Granularität von Pinguin 4.0 es negativen SEOs erleichtern könnte, die SERPs für ein bestimmtes Keyword oder eine Mikro-Nische zu übernehmen, ohne entdeckt zu werden.

5 häufige Fehler bei der Entfernung von Links

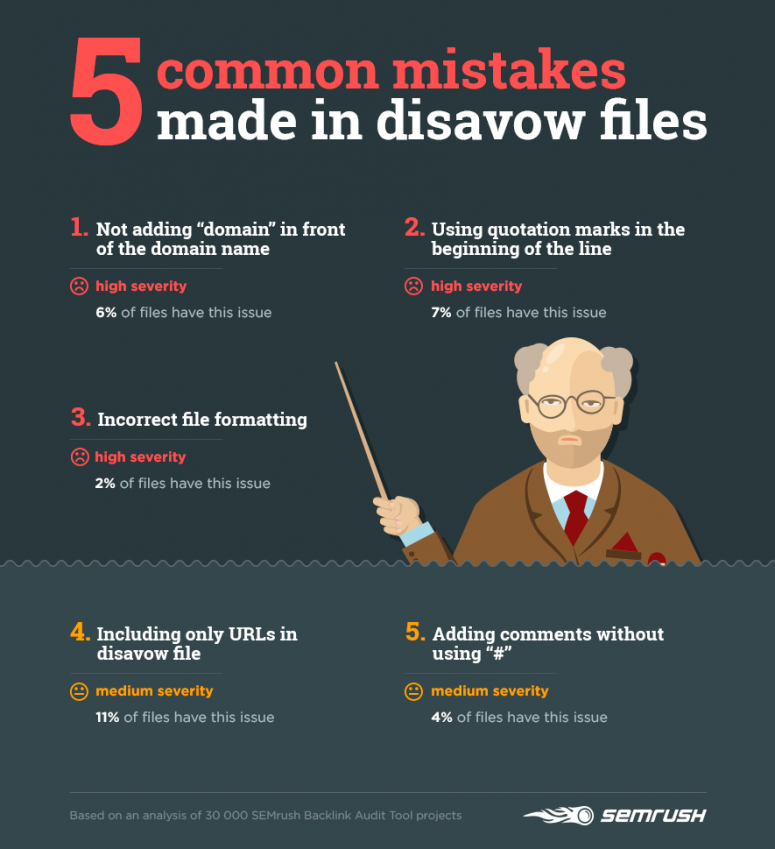

Ich habe bereits darauf hingewiesen, dass es mit Pinguin 4.0. absolut notwendig ist, die Backlinks regelmäßig zu überwachen und gefährliche Links zu entfernen. Wir haben 30 000 Kampagnen analysiert, die mit dem SEMrush Backlink Audit Tool erstellt wurden, um zu sehen, wie SEOs Links disavowen und ihre häufigsten Fehler identifizieren.

21 Prozent der Disavow-Dateien, die wir untersucht haben, entsprechen nicht den Google Search Console Regeln. Schauen wir uns die am häufigsten gemachten Fehler an:

1) Nicht das Hinzufügen von „domain“ vor dem Domainnamen, wenn man Links von einer ganzen Domain disavowiert

Google erkennt nur Zeilen, die mit http oder domain beginnen. Wenn Sie www.domain.com schreiben, wird Google diese Zeile ignorieren und nicht disavowen.

Korrekt: domain: mydomain.com

Korrekt: mydomain.com

2) Die Verwendung von Anführungszeichen am Anfang einer Zeile

Auch hier ignoriert Google einfach eine Zeile, die mit etwas anderem als http oder domain beginnt.

Korrekt: http://www.domain.com/index.html

Korrekt: ‚http://www.domain.com/index.html‘

3) Falsche Dateiformatierung

Die Verwendung eines falschen Zeilentrenners in einigen Tools kann dazu führen, dass mehrzeilige Daten in einer einzigen Zeile zusammengefasst werden. Google ist dann nicht in der Lage, die Datei korrekt zu erkennen und die Disavow-Regeln anzuwenden.

4) Nur URLs in die Disavow-Datei aufnehmen

Manchmal kann ein Link von einem einzigen Artikel auf einigen anderen Seiten einer Website erscheinen – zum Beispiel auf Seiten mit den Top-Posts des Monats, Posts nach Kategorie usw. Wenn Sie also sicherstellen wollen, dass Google die Verbindung zwischen Ihrer Website und einer bestimmten Website nicht berücksichtigt, reicht es nicht aus, eine bestimmte URL zu disavowieren. Sie müssen die gesamte Domain disavowieren.

5) Hinzufügen von Kommentaren ohne Verwendung von „#“

Die Angabe von Kommentaren in Ihrer Disavow-Datei ist nicht obligatorisch. Wenn Sie sich jedoch entscheiden, zusätzliche Informationen bereitzustellen, stellen Sie sicher, dass sie Google nicht daran hindern, Ihre Datei zu analysieren.

Nach dem Hochladen Ihrer Disavow-Datei sollten Sie immer überprüfen, wie viele Zeilen Google korrekt erkannt hat. Wenn die Anzahl nicht mit der Anzahl der Zeilen in Ihrer Anfrage übereinstimmt, überprüfen Sie die Datei auf Übereinstimmung mit den Regeln des GSC.

Wir empfehlen Ihnen, so bald wie möglich mit der Überprüfung Ihres Backlink-Profils zu beginnen und sich daran zu gewöhnen, dies regelmäßig zu tun.