El viernes pasado compartimos una gran noticia con los SEOs de todo el mundo: Google ha anunciado oficialmente el lanzamiento de su actualización Penguin 4.0. Penguin ahora pasa a formar parte del núcleo del algoritmo de Google y se ejecuta en tiempo real.

Antes de ver qué impacto tendrán estos cambios en la industria de las búsquedas, echemos un vistazo atrás.

El mundo oyó hablar por primera vez de la actualización Penguin en abril de 2012. Su objetivo principal era hacer frente a los sitios web que habían adquirido enlaces de forma no natural con el fin de aumentar su clasificación. Después de que Google pusiera en marcha esta actualización, que afectó a cerca del 3,1% de las consultas, un montón de sitios web fueron objeto de una penalización de Google y salieron de la búsqueda como resultado. De este modo, las reglas del juego cambiaron por completo y comenzó una nueva era en la construcción de enlaces.

La recuperación de una penalización de Google siempre ha llevado mucho tiempo, y la nueva versión de Penguin que Google puso en marcha el 23 de septiembre trajo consigo algunos cambios significativos. «Históricamente, la lista de sitios afectados por Penguin se actualizaba periódicamente al mismo tiempo. Ahora Penguin es en tiempo real, por lo que los cambios serán visibles mucho más rápido, normalmente surtiendo efecto poco después de que volvamos a rastrear y reindexar una página», escribió Gary Illyes en el blog para webmasters de Google.

Repasemos las principales características de Penguin 4.0 y veamos cómo afectarán al trabajo de los especialistas en SEO:

-

Penguin 4.0 se lanzó para todos los países e idiomas al mismo tiempo. Esto significa que todos los sitios web experimentarán el mismo impacto independientemente de su ubicación; las reglas son las mismas para todos.

-

Penguin es ahora en tiempo real. Esto implica que los rankings de cualquier página muchos cambian cada vez que Google actualiza la información sobre esta página y sobre las páginas que la enlazan. Así, tanto los impactos positivos como los negativos de sus acciones se harán notar más rápidamente.

-

El algoritmo en tiempo real le permite recuperarse de una penalización de Google más rápidamente. Si tu sitio es penalizado y tu webmaster hace un buen trabajo mejorándolo y eliminando los enlaces dañinos, verás resultados positivos antes, justo después de que Google vuelva a rastrear las páginas de tu sitio web.

-

A partir de ahora, Penguin es una parte del algoritmo principal de Google, no un filtro independiente. Por eso hemos visto el último anuncio oficial de Google sobre la actualización. Ahora tendrás que supervisar continuamente tu perfil de backlinks.

-

Penguin se está volviendo más granular. Sencillamente, el algoritmo se centra ahora en las páginas específicas a las que apuntan los enlaces tóxicos, en lugar de en los sitios web completos. Estas micropenalizaciones son más difíciles de rastrear, por lo que ahora es esencial auditar todos los subdominios importantes y las páginas específicas de su sitio web de forma regular.

¿Cómo beneficiarse de Penguin 4.0?

Una de las razones por las que Penguin es tan peligroso es porque nunca se le informará si su sitio web está penalizado. Sólo puede asumir que fue penalizado por señales indirectas, como una fuerte caída en el tráfico orgánico o la disminución de las posiciones para algunas (o todas) de sus palabras clave, incluyendo las de marca.

Debido a que el algoritmo actualizado le permite ver los resultados de sus acciones rápidamente, puede ser un arma de doble filo. El proceso de recuperación se hace más rápido, pero también el de penalización. Esto es lo que puede hacer para proteger su sitio web de caídas inesperadas en las clasificaciones:

-

Monitoree constantemente sus posiciones en las SERPs. Configure alertas de correo electrónico regulares para mantenerse informado de cualquier cambio de posición. Asegúrese de que está siguiendo no sólo las palabras clave para las que se clasifica su página de inicio, sino también las palabras clave para todas las subdivisiones significativas. Tom Clark sugiere «comparar las clasificaciones de las palabras clave e investigar qué palabras clave han tenido una caída repentina en su posición»

-

Mantenga su perfil de backlinks sano y limpio. Acostúmbrese a comprobar regularmente los backlinks nuevos y perdidos, su valor y calidad, y a manejar los sospechosos.

-

Realice una auditoría profunda de backlinks de todo su sitio web. Debido a que el nuevo Pingüino tiene un enfoque granular, es esencial auditar los backlinks para cada subdominio y subdivisión importante de su sitio web (por ejemplo, realizar una auditoría por separado para cada una de las diferentes versiones de idioma de su sitio web).

-

Configura las propiedades en Google Search Console para cada subdominio o subdivisión importante y actualiza tu archivo de desautorización según sea necesario. Puede utilizar la herramienta SEMrush Backlink Audit para formatear fácil y correctamente los archivos de desautorización.

La actualización de Penguin y el futuro de la construcción de enlaces

En general, la característica de «tiempo real» de Penguin implica que puede recuperarse de la penalización más rápidamente. La nueva actualización permite llevar a cabo diversos experimentos con un coste de error reducido -siempre que se sea competente y cuidadoso.

Sin embargo, esto podría, en teoría, llevar a los SEOs astutos a intentar engañar al sistema y manipular de nuevo los resultados de las SERP -por ejemplo, adquiriendo artificialmente backlinks para subdominios o URLs concretas y observando la reacción de Google a sus experimentos. Hemos pedido a algunos expertos que compartan su opinión sobre si la nueva actualización de Penguin va a dar lugar a una nueva ola de optimización de sombrero gris.

Sospecho que la naturaleza en tiempo real hará que sea difícil para los spammers saber si fueron golpeados por Panda, Penguin, o algo más. Así que no estoy seguro de si lo hará más fácil o más difícil. El tiempo lo dirá.

En resumen, no. No creo que el hecho de que Penguin se traslade al núcleo del algoritmo y se ejecute en «tiempo real» conduzca a una mayor optimización de sombrero gris, por dos razones:

1. El tiempo real no es instantáneo.

Aunque Google utilice el lenguaje «en tiempo real» seguirá habiendo un tiempo de retraso en ver los resultados de los nuevos enlaces asegurados. En teoría, sólo ocurrirá cuando Google rastree tanto su página como la página que enlaza con su sitio.

2. Google declaró que esta actualización hizo que Penguin fuera «más granular».

El lenguaje exacto que Google utilizó para describir la naturaleza granular de Penguin: «Penguin ahora devalúa el spam ajustando la clasificación en función de las señales de spam, en lugar de afectar a la clasificación de todo el sitio».

Algunos SEOs han teorizado que el nuevo algoritmo Penguin podría simplemente ignorar los enlaces de spam, en lugar de aplicar una medida punitiva. El algoritmo Penguin afectaría más a las páginas que a los sitios, según las declaraciones de Google. Esto derrotaría en gran medida al SEO negativo, pero también ofuscaría aún más el efecto de los enlaces de sombrero gris diseñados para probar y manipular a Penguin.

En resumen, creo que será extremadamente difícil medir y comprender realmente el efecto de los enlaces manipuladores en el algoritmo Penguin. Google tiende a mejorar con el tiempo, y creo que esta nueva actualización continuará esa tendencia.

Creo que hay un par de cosas para preocuparse con esta nueva implementación de Penguin.

Google ha dado efectivamente el poder de experimentar (y tal vez manipular el algoritmo) de nuevo a aquellos que tienen la capacidad de gastar tiempo y recursos en él. Veo dos grupos clave que podrían aprovecharse de esto de maneras que pueden ser perjudiciales, tanto para los competidores como para la calidad general de las SERPs.

En primer lugar, aquellos con una inclinación por empujar los límites experimentales con el fin de obtener información sobre el funcionamiento del algoritmo principal de Google. Para estas personas, las incógnitas son ahora capaces de ser probadas, los límites empujados, y los SERPs impactados una vez más.

Tal vez más preocupante es el espectro de dar a los operadores maliciosos la capacidad de probar realmente la eficacia de los esfuerzos de SEO negativo. Aunque el objetivo declarado de Google siempre ha sido garantizar que el algoritmo Penguin sea inmune al SEO negativo, los primeros indicios no son buenos. El primer cliente que se puso en contacto conmigo tras el lanzamiento del nuevo algoritmo Penguin fue el propietario de un negocio que llevaba meses observando la construcción de un número masivo de enlaces de spam hacia su sitio, ignorándolos por consejo de quienes creían que «Google es generalmente muy bueno en la identificación del SEO negativo». Veinticuatro horas después del lanzamiento, su sitio había sufrido un golpe significativo en la visibilidad.

Aunque estoy contento de tener finalmente un pingüino más sensible en el bloque, hay mucho que ver como todo esto se sacude. Mientras tanto, seguiremos centrándonos en ayudar a los que se enfrentan a las acciones manuales, para los que nada cambia si no se trabaja duro y se presta atención a los detalles.

Cada día aprendemos más y más con Penguin, lo cual es impresionante. El otro día dije que probablemente el disavowing ya no sería necesario, ¡y tenía razón! Gary lo confirmó ayer. Y luego explicó que las penalizaciones anteriores de Penguin (supresión) se estaban eliminando en los próximos días. Eso es una GRAN noticia.

De todos modos, voy a esperar hasta que lleguen más datos. He estado analizando mucho muchos dominios que fueron impactados anteriormente. Creo que la próxima semana será muy interesante.

Aunque es un poco pronto para valorar esta noticia, hay un par de aspectos interesantes: el Pingüino pasa a formar parte del algoritmo central de Google y, por tanto, se convierte en un factor de ranking. Si es cierto, significa que en cuanto alguien intente engañar a Google, el algoritmo ajustará inmediatamente los rankings. En Bruce Clay estamos analizando este impacto real, y tendremos más datos y análisis a finales de octubre.

¡No creo que nada de lo que ha hecho Google haya impedido a los SEOs encontrar formas de engañar al sistema! Pero sí, puedo ver cómo Penguin 4.0 podría ser una ventaja para los SEOs que experimentan con enlaces artificiales. Todo el mundo ha estado hablando de esto desde que se anunció Pingüino 4.0, pero es demasiado pronto para decir si este es realmente el caso.

Los SEOs de sombrero gris ciertamente tendrán que adaptar sus procesos, los SEOs de sombrero negro también. Es como el uso de drogas en el atletismo; a menos que seas sobrehumano, sabes que para ganar puedes tener que aumentar artificialmente tu rendimiento, pero si te pillan, tu carrera podría acabar para siempre. Lo más preocupante para mí es que la granularidad de Penguin 4.0 podría facilitar que los SEOs negativos se apoderen de las SERPs para una palabra clave o un micronicho en particular sin ser detectados.

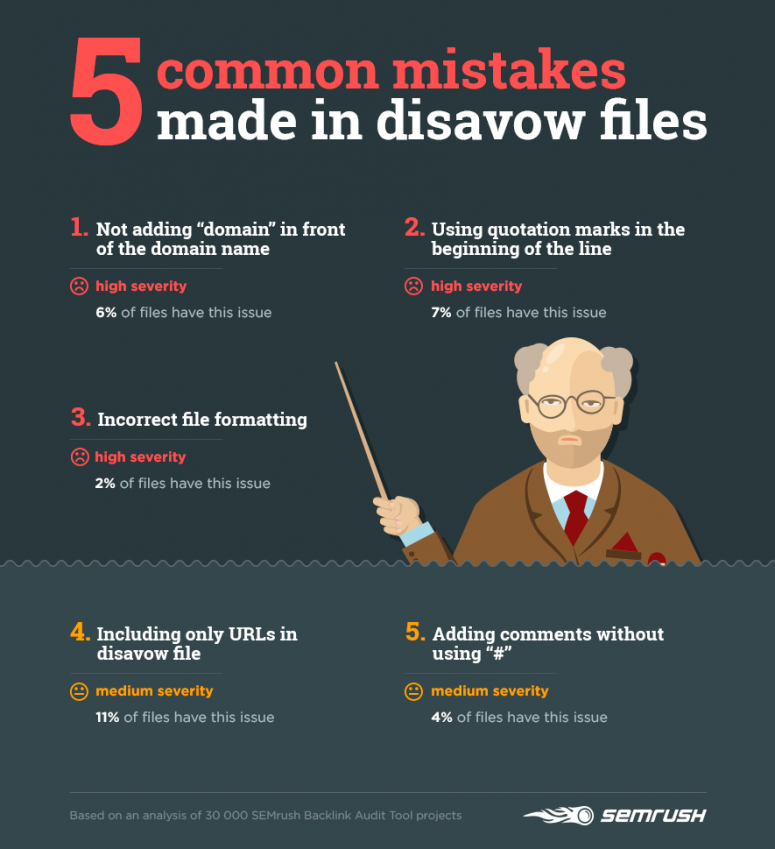

5 errores comunes que se cometen al desautorizar enlaces

Ya he señalado que al estar en tiempo real Penguin 4.0. hace que sea absolutamente esencial monitorear regularmente tus backlinks y deshacerte de los peligrosos. Hemos analizado 30 000 campañas creadas en la herramienta SEMrush Backlink Audit para ver cómo los SEOs desautorizan enlaces e identificar sus errores más comunes.

El 21% de los archivos de desautorización que hemos investigado no cumplen con las reglas de Google Search Console. Veamos los errores que se cometen con más frecuencia:

1) No añadir «dominio» delante del nombre del dominio cuando se desautorizan enlaces de un dominio completo

Google solo reconoce las líneas que empiezan por http o dominio. Si escribes www.domain.com, Google ignorará esta línea y no la desautorizará.

Correcto: dominio: midominio.com

Incorrecto: midominio.com

2) Usar comillas al principio de una línea

De nuevo, Google simplemente ignorará una línea que comience con cualquier cosa excepto http o dominio.

Correcto: http://www.domain.com/index.html

Incorrecto: ‘http://www.domain.com/index.html’

3) Formato de archivo incorrecto

El uso de un separador de líneas incorrecto en algunas herramientas puede hacer que los datos de varias líneas se fusionen en una sola. Google no podrá reconocer el archivo correctamente y aplicar las reglas de desautorización.

4) Incluir sólo las URL en el archivo de desautorización

A veces, un enlace de un solo artículo puede aparecer en otras páginas de un sitio web, por ejemplo, en las páginas que presentan las principales publicaciones del mes, las publicaciones por categoría, etc. Por lo tanto, si quiere asegurarse de que Google no tiene en cuenta la conexión entre su sitio web y un sitio web específico, no basta con desautorizar una URL concreta. Necesita desautorizar todo el dominio.

5) Añadir comentarios sin usar «#»

Comentar su archivo de desautorización no es obligatorio. Sin embargo, si decide proporcionar información adicional, asegúrese de que no impida que Google analice su archivo.

Después de subir su archivo de desautorización, compruebe siempre cuántas líneas ha reconocido Google correctamente. Si el número no coincide con el número de líneas de su solicitud, compruebe que el archivo cumple con las normas de GSC.

Le recomendamos que empiece a auditar su perfil de backlinks lo antes posible y que se acostumbre a hacerlo con regularidad.